Candriam gestore globale con focus su investimenti sostenibili e multi-asset, a un anno dal lancio della sua iniziativa per gli investitori sulla tecnologia di riconoscimento facciale (in acronimo FRT), ha pubblicato un aggiornamento relativo all’attività di engagement intrapresa per affrontare i rischi per i diritti umani posti da questa tecnologia.

Candriam, insieme ad altri 20 investitori, tra cui Aviva Investors, Domini Impact Investments LLC e Robeco, ha condotto un’indagine su 15 aziende coinvolte nell’FRT per capire come queste valutano, gestiscono e mitigano i rischi legati ai diritti umani.

Il rapporto ha evidenziato quattro aree principali di criticità: il potenziale rischio di bias razziale e di genere, la discutibile precisione della tecnologia, i problemi di privacy e l’uso improprio dell’FRT.

Fra le principali conclusioni:

- La regolamentazione sta faticando a tenere il passo con la tecnologia. È quindi essenziale che le aziende vadano al di là dei requisiti legali e si concentrino su ciò che è etico. Le aziende che parlano chiaramente di etica dell’intelligenza artificiale (“AI”) e di un approccio responsabile all’FRT sono un segnale positivo dell’attenzione e della considerazione a queste problematiche, e di solito ciò è evidente in tutte le prassi operative di un’azienda.

- Le aziende dovrebbero disporre di una governance specifica per i rischi legati ai diritti umani e dovrebbero pubblicare una policy dettagliata in materia di diritti umani, con riferimenti alle modalità di utilizzo dell’AI e dell’FRT.

- La tecnologia che abilita una categorizzazione introduce troppe potenziali discriminazioni e violazioni dei diritti umani e dovrebbe essere evitata a tutti i costi.

- Le aziende sono incoraggiate a evitare la vendita di tecnologie di riconoscimento facciale alle forze dell’ordine fino a quando non verrà introdotta una regolamentazione adeguata.

- L’FRT dovrebbe limitarsi a fornire supporto all’attività umana di identificazione e autenticazione.

Tre aziende che si sono distinte per i loro sforzi nel mitigare i rischi per i diritti umani dell’uso dell’AI e dell’FRT sono state Microsoft, Motorola Solutions e Thales:

- Microsoft ha implementato una governance solida in materia di utilizzo etico dell’AI e in particolare dell’FRT e ha recentemente ritirato le funzionalità di classificazione facciale. Inoltre, Microsoft è una delle prime aziende tecnologiche ad aver posto una moratoria sulla vendita di tecnologie di riconoscimento facciale alle forze dell’ordine.

- Motorola sottolinea che l’FRT deve assistere gli esseri umani piuttosto che prendere decisioni e ha integrato l’autenticazione a due fattori nella propria tecnologia.

- Il controllo passaporti assistito dalla tecnologia FRT di Thales richiede un monitoraggio rigoroso e prevede la distruzione dei dati degli utenti dopo ogni passaggio.

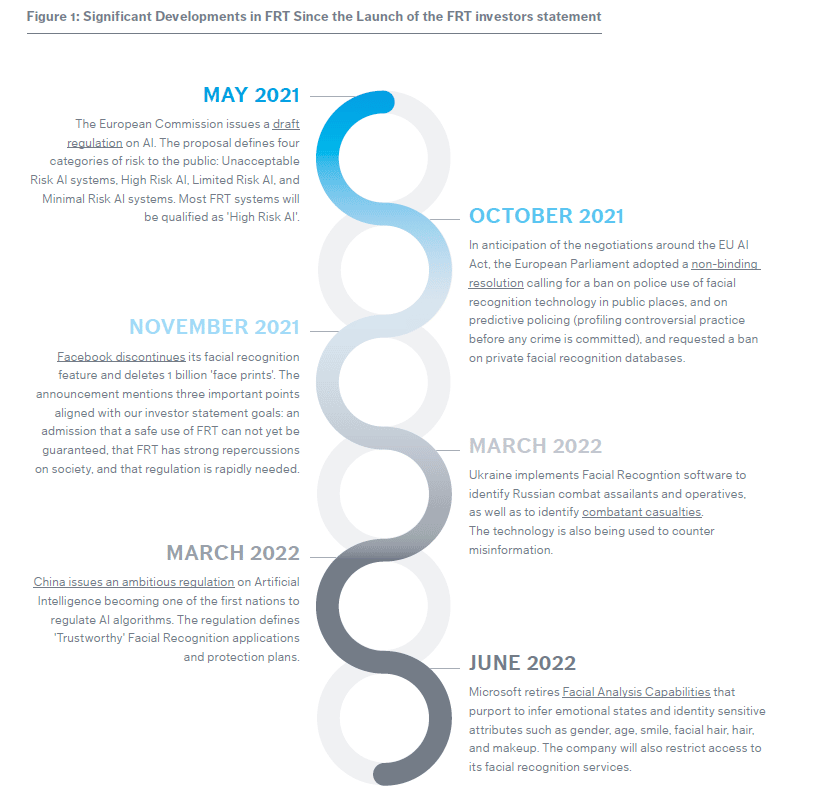

Questo aggiornamento sui risultati dell’attività di engagement sulle tecnologie di riconoscimento facciale fa seguito alla campagna lanciata da Candriam a marzo 2021 e alla firma dell’Investor Statement sul riconoscimento facciale da parte di 55 investitori globali a giugno 2021.

Dopo la stesura del report, Candriam dialogherà con ogni azienda su come implementare le best practice suggerite nelle rispettive attività. I risultati di questa seconda fase dell’iniziativa di engagement dovrebbero essere resi noti nel 2023.

Candriam ha inoltre aderito alla Collective Impact Coalition (CIC) for Digital Inclusion, recentemente lanciata dalla World Benchmarking Alliance, per promuovere l’uso responsabile dell’AI.

Benjamin Chekroun, analista su Proxy Voting ed Engagement di CANDRIAM, ha dichiarato: “La velocità con cui si evolve la tecnologia di riconoscimento facciale e il ritardo nella relativa regolamentazione rendono necessarie una maggiore sorveglianza e comprensione da parte delle aziende coinvolte in questo settore per garantire la tutela dei diritti umani. In qualità di investitori responsabili nel settore tecnologico, abbiamo un ruolo importante da svolgere nell’incoraggiare le società in cui investiamo a identificare, gestire e mitigare i rischi per i diritti umani nell’uso dell’AI e dell’FRT. Ci auguriamo che il nostro report e i suoi risultati spingano le aziende ad adottare una due diligence e a monitorare il rispetto dei diritti umani, inducendole a esaminare queste problematiche, a prenderne atto e ad affrontare i rischi posti dall’FRT”.

Louise Piffaut, Senior ESG analyst di Aviva Investorsha aggiunto: “Noi di Aviva Investors siamo soddisfatti del report, che rappresenta un’importante pietra miliare per questa iniziativa di collaborazione. Poiché la regolamentazione nel settore tecnologico è ancora limitata, le aziende non sono ancora pienamente consapevoli delle loro responsabilità nella gestione degli impatti sociali dell’FRT, che dipendono dalla posizione nella catena del valore. Gli investitori hanno un ruolo importante da svolgere nell’indicare le best practice e nel coinvolgere le aziende su questo tema”.

Per scaricare il report (in inglese) cliccare su questo link o sull’immagine qui sotto.